Gemma 2の日本語継続事前学習モデル「Gemma 2 Baku 2B」シリーズを公開

AIニュースの要約

- rinna株式会社が日本語継続事前学習モデル「Gemma 2 Baku 2B」シリーズを公開。

- Gemma 2 2Bは高性能なテキスト生成能力を持つ軽量モデルで、800億トークンを使用して日本語能力を強化。

- 「Gemma 2 Baku 2B Instruct」は指示学習を通じて人間との対話に最適化されたモデル。

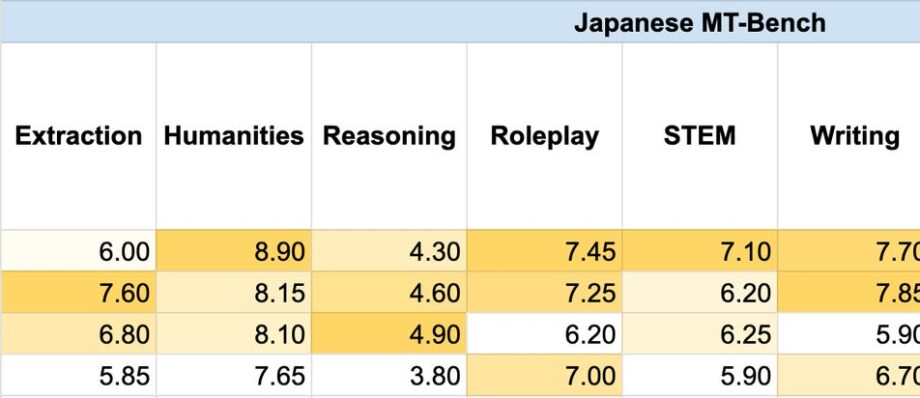

- 公開されたモデルは、特に日本語における性能が改善されたことがベンチマーク結果から確認できる。

- rinnaはカスタムLLMソリューション「Tamashiru Custom」を提供し、AIの社会実装を推進中。

AIニュースの背景(推測)

生成AIの急速な普及と進化が、その背景にあると考えられます。特に、テキスト生成技術が普及する中で、ユーザーが多様なアプリケーションに応じた高性能な日本語モデルの必要性を感じている状況です。日本市場に特化したAIモデルの開発は、国内企業の競争力を強化するための重要な要素となっています。rinnaは、これまでの研究やモデルの公開を通じて、多くのフィードバックとデータを蓄積し、その知見を基にしたさらなる進化を目指していると推測されます。

AIニュースの内容(詳細)

rinna株式会社は、日本語継続事前学習モデル「Gemma 2 Baku 2B」シリーズを発表しました。このモデルは、Googleが公開している大規模言語モデル「Gemma 2 2B」に基づいており、日本語と英語の学習データを用いて800億トークンで継続的に事前学習されました。その結果、Gemma 2 2Bの日本語能力が大幅に強化されています。

「Gemma 2 Baku 2B」というモデル名は、妖怪の「獏」からきており、文化的な要素も含んでいます。また、同シリーズには「Gemma 2 Baku 2B Instruct」というモデルがあり、これは指示学習を通じて人間との対話に特化したものです。これらのモデルは高いコストパフォーマンスを持ち、利用目的に応じた追加学習が容易である点が魅力です。

ベンチマーク結果によれば、Gemma 2 Baku 2Bシリーズは、従来のGemma 2 2Bモデルに比べて日本語の性能が改善されており、具体的には、対話性能においてはGemma 2 Baku 2B Instructが26億パラメータのモデルであるにもかかわらず80億パラメータのモデルよりも高いスコアを達成しています。このことは、ユーザーが実際に使えるテキスト生成を行う上で非常に重要な要素となります。

今後、rinnaはこれまでの知見を生かし、さらに目的に応じたLLMのカスタマイズソリューション「Tamashiru Custom」の提供を通じて、ビジネスニーズに応じたAIソリューションの開発を進めていく予定です。

ビジネスで活用する方法・可能性

Gemma 2 Baku 2Bシリーズは、ビジネスの多くの場面で活用可能です。特に情報生成が求められるマーケティングやコンテンツ制作において、高性能な日本語モデルは大きな強みとなります。例えば、マーケティングチームは、SEO対策に特化した記事生成、SNS投稿用のコンテンツ作成、顧客への対応メールなどにこのAIモデルを活用できます。

さらに、カスタムモデル「Tamashiru Custom」を通じて、自社の業務プロセスに特化したモデルが提供されるため、特定のビジネスニーズに応じた最適化が容易になります。例えば、ユーザーからの問い合わせに迅速かつ適切に対応できるチャットボットを開発する際には、この技術を活用することで、コストを抑えつつ高品質なサービスを実現することが可能になります。

また、eラーニングや教育分野においても、Gemma 2 Baku 2Bシリーズを使用することで、生徒の理解度に応じた自動応答システムを構築することも期待されます。これにより、対話形式での学習を促進し、各生徒に合わせた学習体験を提供することができます。

加えて、ビジネスインテリジェンスやデータ分析分野でも応用が考えられます。膨大なデータから有益な情報を生成し、意思決定をサポートするツールとして利用することで、企業の競争力を高めることが可能になります。

このように、Gemma 2 Baku 2Bシリーズは、さまざまなビジネス用途に対応できる高性能な日本語モデルであり、企業の効率化や業務改善に寄与する可能性が大いにあります。今後、AI技術の進化が続く中で、より多様なアプリケーションが現れることでしょう。

Gemma 2の日本語継続事前学習モデル「Gemma 2 Baku 2B」シリーズを公開Gemma 2 2Bのテキスト生成能力やコストパフォーマンスを活かしつつ日本語能力を強化rinna株式会社2024年10月3日 13時00分8rinna株式会社 (本社:東京都渋谷区/代表取締役:宋 珠憲、以下rinna) は、Gemma 2 2Bに対して日本語継続事前学習と指示学習を行った「Gemma 2 Baku 2B」シリーズを開発し、Gemma Terms of Useで公開したことを発表します。

■ rinnaのモデル公開活動

生成AIは多くの製品で活用され始め、急速に普及しています。この普及の背景には、高性能な基盤モデルが利用しやすいライセンスで公開されていることが挙げられます。rinnaでは、日本のAI技術発展のために、日本語のタスクに適したGPT・BERT・HuBERT・CLIP・Stable Diffusionなど、テキスト・音声・画像に関する基盤モデルを公開してきました。2021年4月からHugging Faceに公開してきたrinnaのモデルは、累計690万ダウンロード、1100件を超えるLikesを記録しており、多くの研究・開発者に利用されています。そしてこの度、より使いやすく高性能な日本語LLMを目指し、Google社が公開している大規模言語モデル (LLM: large language model) であるGemma 2 2Bに対し、日本語継続事前学習した「Gemma 2 Baku 2B」と、指示を遂行するように指示学習した「Gemma 2 Baku 2B Instruct」を開発し、公開しました。これらのモデル公開が、日本のAI研究・開発の一助となれば幸いです。

・Gemma 2 2Bの日本語継続事前学習モデル「Gemma 2 Baku 2B」シリ

出典 PR TIMES